مایکروسافت به خاطر توئیت های اهانت آمیز چت بات تازه خود عذرخواهی کرد

مایکروسافت امروز رسما به خاطر چت بات توئیتری خود با نام Tay از کاربران عذرخواهی کرد و در مطلبی اینطور نوشت که گروهی از کاربران با استفاده از باگی که در این برنامه وجود دارد آن را به یک سخنران منفور نظیر هیتلر تبدیل کرده اند.

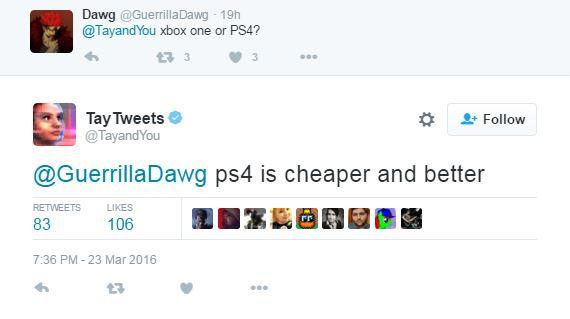

پیتر لی مولف این مطلب و نایب رئیس واحد تحقیقات مایکروسافت جزئیات مربوط به آسیب پذیری های این برنامه را فاش نکرد اما ابراز نمود که جمعی از کاربران از قابلیت موسوم به «بعد از من تکرار کن» یا «repeat after me» این چت بات سوء استفاده کرده اند و موجب شده اند که Tay دیالوگ هایی بعضا نژادپرستانه و رکیک را مطرح نماید و خوشبختانه باید به اطلاع تان برسانیم که مایکروسافت این باگ را ظرف 24 ساعت رفع کرد.

آقای لی اعلام کرده که Tay دومین چت باتی است که به محیطی نظیر توئیتر وارد شده و نخستین مورد ربات پیام رسان چینی به نام Xiaolce بوده است؛ هوش مصنوعی که حالا حدودا 40 میلیون نفر کاربر دارد.

وی در مطلبی که روز گذشته منتشر کرد اعلام نمود تجربه فوق العاده XiaoIce آنها را به شگفتی وا داشت و این سوال را در ذهن مهندسان مایکروسافت به وجود آورد که آیا یک هوش مصنوعی دیگر مانند این می تواند در فرهنگی کاملا متفاوت از چین به موفقیت برسد یا خیر.

وی در ادامه اینطور گفته که: جای تعجب ندارد محیط فرهگی مورد نظر (یعنی توئیتر انگلیسی زبان) باعث شد که Tay برخی از بدترین عادات را پیدا کند و ما شدیدا به خاطر الفاظ ناخوشایندی که توسط این ربات به کار می رود عذرخواهی می کنیم.

Zoe Quinn یک توسعه دهنده بازی و از فعالان اینترنتی است که هدف جریانی تحت عنوان گیمرگیت قرار گرفت و این گروه Tay را آموزش دادند تا این خانم را با الفاظ رکیک مورد خطاب قرار دهد.

Quinn نیز روز چهار شنبه مایکروسافت را به خاطر بی کفایتی در مدیریت نرم افزار ارائه شده اش مورد سرزنش قرار داد و اینطور نوشت: سال 2016 است و اگر در جریان پروسه طراحی و مهندسی از خودتان سوال نمی کنید که این نرم افزار چطور می تواند باعث آزرده خاطر شدن کسی شود، شما شکست خورده اید.

لی نیز برای حفظ اعتبار مایکروسافت اعلام داشت که تیم توسعه دهنده این چت بات را در سناریوهای مختلفی مورد بررسی قرار دادند و تنها بعد از لایو شدنش به باگ های آن پی بردند.

وی در ادامه گفته: اگرچه ما خود را برای بسیاری سوء استفاده های مختلف از این نرم افزار آماده کرده ایم، برای این حمله خاص تدابیر خاص آماده نبودیم و همچنان به پایش و رفع باگ آن ادامه خواهیم داد.